Nivel Principiante

Imagina que tienes una página web y no quieres que los buscadores como Google entren a ciertas partes de tu sitio, como las páginas privadas de tus usuarios. El archivo robots.txt es como un letrero de «no pasar» para los robots de los buscadores. Es un archivo de texto simple que les dice a estos robots qué partes del sitio pueden visitar y cuáles no. Es una forma de controlar qué contenido quieres que se muestre en los resultados de búsqueda.

Nivel Intermedio

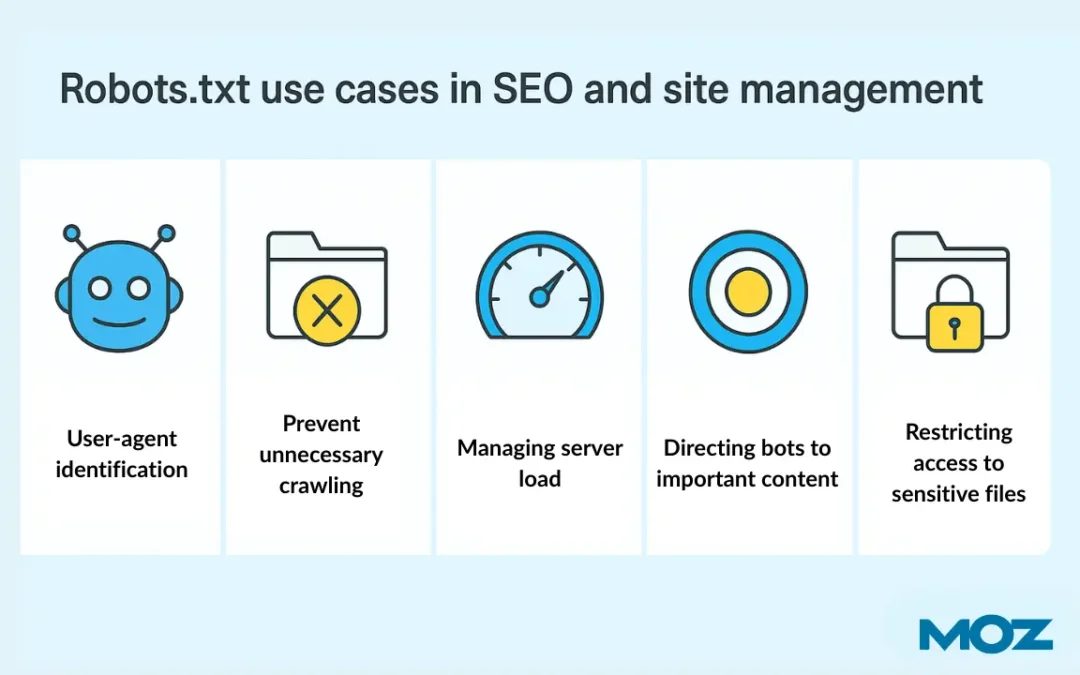

El robots.txt es un archivo de texto simple que se encuentra en la raíz de un sitio web (https://www.ejemplo.com/robots.txt) y que sirve para comunicarse con los rastreadores web o bots. Su propósito es proporcionar instrucciones a los robots sobre qué partes del sitio pueden rastrear. Es parte del Protocolo de Exclusión de Robots y se utiliza en el contexto del SEO Técnico.

Las directivas más comunes en un archivo robots.txt son:

User-agent: Especifica el nombre del bot al que se dirigen las reglas (por ejemplo,Googlebot).Disallow: Le dice al bot que no rastree un directorio o una URL específica.Allow(no es un estándar, pero es usado por Google): Sirve para permitir el rastreo de archivos o directorios específicos dentro de un directorio que ha sido bloqueado.Sitemap: Permite especificar la ubicación de un Sitemap XML.

Es importante recordar que el robots.txt es una recomendación y no una imposición. Un bot malicioso puede ignorar las instrucciones, por lo que no es una herramienta para la seguridad.

Nivel Avanzado

Técnicamente, el robots.txt es un archivo de texto plano que sigue un formato específico de «grupo de reglas». Un grupo de reglas consiste en un User-agent y una o más directivas.

Un ejemplo de un archivo robots.txt es:

User-agent: *

Disallow: /admin/

Disallow: /privado/

User-agent: Googlebot

Disallow: /no-google/

Sitemap: https://www.ejemplo.com/sitemap.xmlEste ejemplo le dice a todos los bots (*) que no rastreen los directorios /admin/ y /privado/. También le dice al bot de Google (Googlebot) que no rastree el directorio /no-google/, pero permite que otros bots sí lo hagan. Finalmente, especifica la ubicación del sitemap.

Es crucial entender que el robots.txt controla el rastreo, pero no la indexación. Si una página está bloqueada en el robots.txt, los motores de búsqueda pueden no rastrearla, pero si hay enlaces a ella desde otros sitios, aún puede aparecer en los resultados de búsqueda. Para evitar la indexación de una página, se debe utilizar la etiqueta <meta name="robots" content="noindex"> o el encabezado HTTP X-Robots-Tag. Un error común es usar robots.txt para bloquear el rastreo de archivos CSS y JS, lo que puede afectar el SEO, ya que Google necesita acceder a ellos para renderizar correctamente la página.